現在位置:

- トップ

- ワークステーション

- CERVO Deep for Linux(Xeon CPU)

- CERVO Deep for Linux Type-DPXX

CERVO Deep for Linux Type-DPXX

Deep Learning ワークステーション(Xeon 2CPU/4GPU対応)

最短 20 営業日~出荷3 年間センドバック方式ハードウェア保証 Deep Learning 用フレームワークをプリインストール済

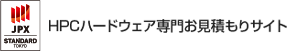

最大 2CPU 第 2 世代 インテル® Xeon® Scalable シリーズ・プロセッサー搭載(PCI Express Gen3)

最大 4TB(256GB x16)Registered-ECC メモリ対応(DDR4-2933 / 12 チャンネル)

最大 4GPU(NVIDIA® Tesla V100S)対応(PCI Express Gen3(x16))

オンサイト・ハードウェア保守対応可能(有償オプション)

オペレーティング・システム

Ubuntu 18.04 LTS

フレームワーク

NVIDIA GPU Cloud(TensorFlow/Pytorch/Chainer)

プロセッサー

[2 基] インテル® Xeon® Gold 5218R プロセッサー(20 コア/2.1GHz)

メモリー

96GB(8GB x12)DDR4-2933 Registered-ECC

ストレージ

480GB 高耐久 SSD + 2TB 高耐久 HDD

光学ドライブ

DVD スーパーマルチ

ネットワーク

[2 ポート] 10 ギガビット

IPMI

[1 ポート] IPMI 2.0

グラフィック(描画)

NVIDIA® Quadro® P620 2GB-GDDR5(PCI Express Gen3(x16))

グラフィック(計算)

NVIDIA® Tesla V100S 32GB-HBM2(PCI Express Gen3(x16))

電源ユニット

[冗長化] 2,200W/200V(1,200W/100V)80 Plus Titanium 認証

保証

3 年間センドバック方式・ハードウェア保証

その他

オンサイト・ハードウェア保守対応(有償オプション)

- 販売価格3,399,000円(税込)

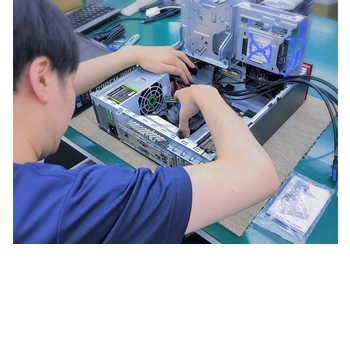

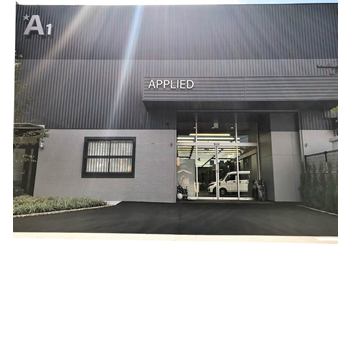

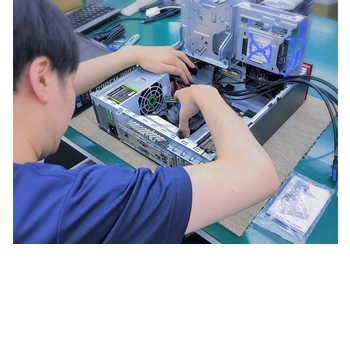

国内自社工場(福岡市)で熟練エンジニアによる生産

高い性能と耐久性を求められる HPC 製品はもちろんのこと、一般事務などで利用される BTO パソコンについても、お客様が安心してご利用いただけるように、自社品質基準をクリアした部材のみを採用し、企画から製造までを自社工場(福岡市)で一貫して行っています。

また、部材供給メーカーや国内正規代理店とも定期的な品質ミーティングを行い、安定した製品のご提供はもちろんのこと、継続的な品質向上に努めています。万が一、製品が故障した場合でも、より迅速で確実な修理対応を可能にするために、製造工場に隣接するサービス部門と連携した修理体制を整えています。

業界屈指の専用検査プログラムによる品質検査

国内自社工場(福岡市)で生産される BTO パソコン・HPC 製品は、専用検査プログラムによる診断を行っています。プロセッサー、メモリー、ストレージなどのコンピューターを構成する各部材に対して、実際に稼動している時と同じ状態を再現した負荷検査を実施します。

例えば、メモリの診断では定評あるメモリ診断アルゴリズム「Jump」をはじめ、数種類の診断アルゴリズムを駆使してエラーを検出します。こうして、ソフトウェア的に負荷をかけることにより、従来の診断ツールでは発見できなかったエラーの検出も可能になりました。

おすすめポイント

Ubuntu 18.04 LTS

動作検証済

統合開発環境

NGC 採用

インテル Xeon®

スケーラブル 2 基

最大 4TB メモリ

12 チャンネル駆動

最大 4 GPU

PCIe 64 レーン

10G LAN 2 ポート

IPMI 2.0 1 ポート

2,200W/200V

冗長化電源

3 年間 センドバック

ハードウェア保証

国内自社工場(福岡市)で熟練エンジニアによる生産

高い性能と耐久性を求められる HPC 製品はもちろんのこと、一般事務などで利用される BTO パソコンについても、お客様が安心してご利用いただけるように、自社品質基準をクリアした部材のみを採用し、企画から製造までを自社工場(福岡市)で一貫して行っています。

また、部材供給メーカーや国内正規代理店とも定期的な品質ミーティングを行い、安定した製品のご提供はもちろんのこと、継続的な品質向上に努めています。万が一、製品が故障した場合でも、より迅速で確実な修理対応を可能にするために、製造工場に隣接するサービス部門と連携した修理体制を整えています。

業界屈指の専用検査プログラムによる品質検査

国内自社工場(福岡市)で生産される BTO パソコン・HPC 製品は、専用検査プログラムによる診断を行っています。プロセッサー、メモリー、ストレージなどのコンピューターを構成する各部材に対して、実際に稼動している時と同じ状態を再現した負荷検査を実施します。

例えば、メモリの診断では定評あるメモリ診断アルゴリズム「Jump」をはじめ、数種類の診断アルゴリズムを駆使してエラーを検出します。こうして、ソフトウェア的に負荷をかけることにより、従来の診断ツールでは発見できなかったエラーの検出も可能になりました。

深層学習(Deep Learning)に最適化された開発環境

ディープ・ラーニングとは、CUDA を使った深層学習研究、多層構造のニューラルネットワークを用いた機械学習の手法の 1 つです。インプットした情報が第 1 層からより深い層に次々と伝達される間に各層で学習が繰り返されて、その過程で特徴量が自動で計算されていくことで、パターンの認識精度が向上するなど、様々な問題の解決に繋がると期待されています。

本モデルは、ディープ・ラーニング(深層学習)に最適な OS (Ubuntu 18.04 LTS)、複雑な設定が必要ない最新の開発環境 Docker が使用できる環境を整えており、インターネットへ接続可能な環境であれば、NVIDIA GPU Cloud(NGC)へ接続して、GPU に最適化された多数のコンテナを Ubuntu 上から簡単にご利用いただけます。( NGC は無料のユーザー登録が必要です。)

ハードウェアの安定動作のみならず、Linux OS や 開発環境の動作を代行して、高品質・安定動作する HPC 専用ワークステーションをご提供します。

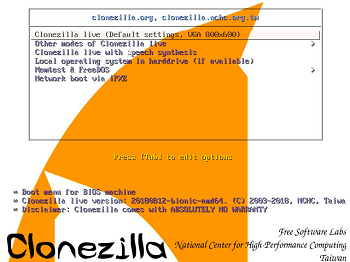

システム環境復元 USB メディア

USB スティックタイプのリカバリ・ディスクを作成してお届けしますので、万が一のトラブル時も安心です。わずか数回のクリックでパソコンを工場出荷時状態まで戻すことができますので、ソフト的な障害や再インストール作業がご不安な方や面倒な方にお勧めです。特に Linux の再インストールが苦手な方には特にお薦めです。

[最大 4 枚] 世界最先端のデータセンター GPU NVIDIA® TESLA® V100S

NVIDIA® Tesla® V100 / V100S は非常に高性能なデータセンター GPU で人工知能、HPC、グラフィックスの処理を加速させます。NVIDIA Volta™ アーキテクチャの力により Tesla V100 / V100S は最大で CPU 100 個分の性能を 1 個の GPU で提供します。これによりデータサイエンティスト、リサーチャー、そして技術者はかつて不可能と思われてきた挑戦に取り組むことができます。

640 個の Tensor コアを搭載しており、Tesla V100S の場合においてディープラーニングのパフォーマンスで 130 TeraFLOPS を提供します。これは Pascal 世代の GPU と比較すると、「トレーニング」時に13倍の Tensor FLOPS、「推論」時に約 6.2 倍の Tensor FLOPS を実現しています。

改良された 900GB / 秒(V100)1134GB / 秒(V100S)の RAW 帯域と利用効率を 95% 向上させたDRAMの組み合わせにより、Telsa V100 / V100S は STREAM での測定において、Pascal 世代の GPU と比較してメモリ帯域が 1.2~1.5 倍増加しています。

AI 推論 ハイ パフォーマンス コンピューティング

Tesla V100 は、AI と HPC を統合するために設計されています。科学的シミュレーションのための計算科学と、データから洞察を見つけるためのデータ科学の両方に優れた HPC システムのプラットフォームを提供します。統一されたアーキテクチャで NVIDIA CUDA® コアと Tensor コアを組み合わせることにより、Tesla V100 GPU を装備したサーバー 1 台で数百台の汎用 CPU のみのサーバーに匹敵する能力が実現し、従来の HPC および AI ワークロードに活用できます。現在、すべての研究者とエンジニアが AI スーパーコンピューターを利用して、最も困難な作業に取り組むことができます。

Tesla V100 は、既存のハイパースケール サーバー ラックのパフォーマンスを最大化するように設計されています。AI をその中心に据えた Tesla V100 GPU は CPU サーバーの 47 倍の推論性能を実現します。スループットと効率性のこの大きな飛躍は、AI サービスのスケールアウトを現実的なものにします。

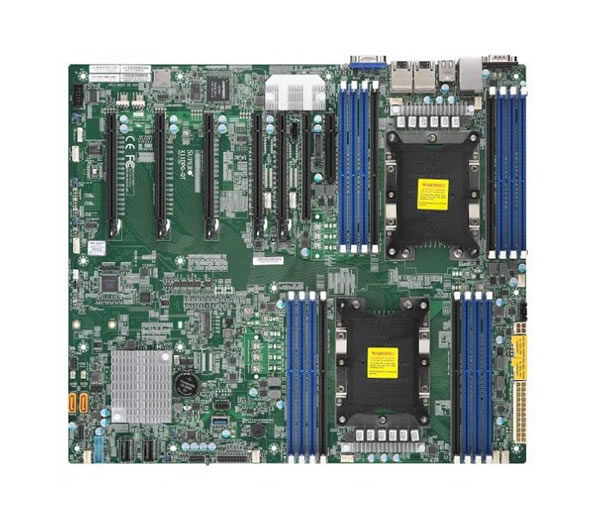

GPU 最大 4 枚を高レーンで同時に動作(PCI-Express レーン数 64)

4-Way 構成に対応することにより、マルチ GPU 設定が可能になり、NVIDIA TESLA V100 を含む最新のグラフィックス技術の力を最大限活用できます。設計、モデリング、医学研究を始め、処理負荷の大きいシミュレーションやレンダリングアプリケーションに最適な性能が実現されます。

PCI-Express 3.0(x16 モード)の GPU を、最大 4 枚で同時に動作させ、最大のパフォーマンスが得られる設計となっています。

また、GPU ボード以外にも、RAID ボードや 10Gbps LAN ボード、InfiniBand ボードなどの増設にも対応できる拡張性も確保しています。

最大 8 基 フロント・ホットスワップ & ラックマウント対応

最大 8 基の 3.5 インチ・ストレージを搭載でき、マウンターを利用することで 2.5 インチ・ストレージも搭載可能です。全てのベイで、ホットスワップに対応していますので、RAID 構成ストレージで障害が発生した場合などでも、運用を止めずにストレージの交換ができます。

また、オプションのレールキットを利用して、デスク・サイドはもちろんのこと、サーバー・ルームでの運用も可能です。

OS に依存せずに動作する IPMI 2.0 に対応した LAN ポートを搭載しているため、プロセッサー温度やファン回転数の監視、リモートでサーバの電源制御などができ、遠隔地やサーバールームに設置したワークステーションのメンテナンスが可能です。ワークステーション管理者が稼動状況を確認でき、障害発生時にワークステーションの起動・再起動などをリモートできるため、運用コストの大幅な低減を実現します。

耐障害性を確保する冗長化電源ユニット

100V 時に 1,200W、240V 時に 2,200W に対応した電源ユニットを 2 個搭載しています。万が一、1 台の電源ユニットが故障しても、もう 1 台の電源ユニットが継続して電源を供給することができる冗長性を確保しています。また、ワークステーションを継続運用するための電力を充分に供給できるため、継続して長時間の計算を実行できます。

[2 基] インテル® Xeon® スケーラブル・プロセッサー(Cascade Lake)

インテル® Xeon® スケーラブル・プロセッサーは、特別な設計により、既存のワークロードに使用していたものと同じハードウェア上で、複雑な AI ワークロードを柔軟に実行することができます。また第 2 世代インテル® Xeon® スケーラブル・プロセッサーは、新しいインテル® ディープラーニング・ブースト(インテル® DL ブースト)をはじめとする AI アクセラレーションにより、エンベデッド AI パフォーマンスをワンランク上の次元に高めます。

インテル® Xeon® スケーラブル・プロセッサーは、Platinum/Gold/Silver/Bronze のラインナップで構成されています。最上位の Platinum では 2.7GHz/tb4.0GHz で最大 28 コア / 56 スレッドで、2/4/8 ソケット構成をサポート、最大 2TB の DDR4-2933 に対応します。高度な分析、シミュレーションとモデリング、人工知能に対応して最適なパフォーマンスを発揮します。

Gold は最大 24 コア / 48 スレッドを用意し、2/4 ソケット構成をサポート、効率性と俊敏性に優れたワークロードに最適します。Silver は最大 16 コア / 32 スレッドで、中程度のタスク向けに最適化され、Bronze は最大 8 コア / 8 スレッドで、軽量なタスク向けに最適化されています。

最大 4TB / 12 チャンネル 構成に対応した Regeistered-ECC メモリー

最新の DDR4 メモリーで、最大 2,933MT/s の高速化に対応しています。また、16 スロットで 、Registered ECC RDIMM の場合は最大 4TB メモリー、 Registered ECC LRDIMM の場合は最大で 4TB メモリーを実装できます。(プロセッサー仕様に依存します)

また、12 スロット以上を利用することで、最大 12 チャンネルのメモリー帯域が利用でき、通信速度が向上します。(12 枚単位でのメモリー実装が、速度及びコストパフォーマンスに優れます)

Registered-ECC 機能により、電気信号の清流・増幅で安定したメモリー・アクセス、クラッシュおよびデータの破損からお客様のシステムを保護します。障害の回避、検出、修正、回復、および不具合の特定と再構成によってプラットフォームおよびデータの整合性を向上させ、内蔵された信頼性、可用性、保守性を実現します。

高効率 80 Plus Titanium 認証電源

コンピューターやサーバーの電源が 20% ~ 100% の負荷環境下において、電源交換効率 80% 以上がスタンダードという基準に対して、80 Plus Titanium は、92% 以上(20% 負荷時)、94% 以上(50% 負荷時)、90% 以上(100% 負荷時)の効率性を発揮する電源ユニットを標準採用しています。

電力変換効率の向上した電源ユニットは、発熱の減少によって冷却ファンの回転数の低下による静音化や電子部品の劣化低減が可能になり、コンピュータの快適性や省電力性の向上と同時に製品寿命も伸びます。

オンサイト・ハードウェア保守(有償オプション)対応

ワークステーションを構成する部材は、すべて「高耐久」「高品質」仕様で構成しています。標準で 3 年間のセンドバック方式ハードウェア保証を装備し、有償ンオプションでオンサイト・ハードウェア保守にも対応しています。

通常のセンドバックサービスとは違い、エンジニアがお客様のところに伺って作業を行いますので、弊社に製品をお送りいただくことなくハードウェアの修理作業をお受けいただけます。ままた、日本全国、お客様の所へお伺いし現地にて修理対応いたします。(※ 沖縄県を除く離島は対象外となります。)

オンサイト・ハードウェア保守の詳しい内容は、こちら をご覧ください。

| モデル名 | APPLIED CERVO Deep for Linux Type-DPXX | |

| 外形寸法 | 約(W)178 x(D)673 x(H)462 mm ※突起部は除く | |

| オペレーティング システム |

標準 | Ubuntu 18.04 LTS |

| 対応 | Ubuntu 18.04 LTS Ubuntu 20.04 LTS |

|

| 開発環境 | NVIDIA GPU Cloud(TensorFlow/Pytorch/Chiner) | |

| 電源ユニット | 定格出力 | 2,200W/200V | 1,200W/100V |

| ユニット数 | 2 基 | |

| 仕様 | 80 Plus Titanium 認証 | 冗長化仕様 | |

| チップ・セット | 名称 | インテル® C621 チップ・セット |

| PCI Express 最大レーン数 |

20 レーン | |

| GPU(計算用) | 名称 | NVIDIA® Tesla® V100S |

| 搭載数 | 1 基 | |

| 最大搭載数 | 4 基 | |

| CUDA コア数 | 5120 コア | |

| Tensor コア数 | 640 コア | |

| メモリー | 16GB | HBM2 | |

| プロセッサー | 名称 | インテル® Xeon® Gold 5218R プロセッサー |

| プロセッサー数 | 2 基 | |

| 動作周波数 | 2.1GHz | Max 4.0GHz | |

| コア数 | 20 コア x2 | 40 スレッド x2 | |

| L3 キャッシュ | 22MB x2 | |

| PCI Express 最大レーン数 |

48 レーン x2 | |

| その他 | Cascade Lake | |

| プロセッサー・ファン | 4U Active CPU Heat Sink | |

| メモリー | 標準 | 96GB(8GB x12) |

| 最大容量 | 4TB | |

| スロット数 | 16 スロット(空き:4 スロット) | |

| 仕様 | DDR4-2666 | Registered-ECC | |

| チャンネル数 | 6 チャンネル x2 | 最大 6 チャンネル x2 | |

| ストレージ (標準) | 容量 | 480GB |

| 規格 | SATA3 | SSD | 耐久仕様 | |

| 読み出し (シーケンシャル) |

550MB/s | |

| 書き込み (シーケンシャル) |

520MB/s | |

| TBW (総書込みバイト量) |

非公開 | |

| MTBF (平均故障間隔) |

200 万時間 | |

| ストレージ(増設) | 容量 | 2TB |

| 規格 | SATA3 | HDD | 高耐久仕様 | |

| 回転数 | 7,200rpm | |

| キャッシュ | 128MB | |

| MTBF (平均故障間隔) |

250 万時間 | |

| 対応 RAID 機能(SATA) | RAID 0/1/5/10 ※ マザーボードの搭載機能です。 ※ OS により対応状況が異なります。 |

|

| 光学ドライブ | DVD スーパーマルチ | |

| グラフィック | 名称 | NVIDIA® Quadro® P620 |

| メモリー | 2GB | GDDR5 | |

| ポート | Mini DisplayPort(DisplayPort 1.4対応):4 ポート Mini DP-DP 変換ケーブル x1 Mini DP-DVI-D 変換ケーブル(シングルリンク対応)x1 |

|

| 最大画面出力 | 最大 4 画面出力 | |

| サウンド | 仕様 | 非搭載 |

| チャンネル | - | |

| ネットワーク | 名称 | インテル® イーサーネット・コントローラー X550 |

| インターフェイス | 10G BASE-T | |

| ポート数 | 2 ポート | |

| IPMI | 名称 | IPMI 2.0 |

| ポート数 | 1 ポート | |

| 各種ポート | USB | USB3.0 x4 (前面 x2/背面 x2) USB2.0 x2 (背面) |

| その他 | RS-232C | |

| 拡張ソケット | M.2 Interface:PCI-E 3.0(x4 Form Factor:2280/22110 Key: M-Key)x1 | |

| 拡張スロット | PCI-E 3.0(x16)x6 PCI-E 3.0(x4 in x8 slot)x1 |

|

| ドライブ・ベイ | 5 インチベイ x3 3.5 インチベイ x1 3.5 インチシャドウベイ(ホットスワップ対応)x8 |

|

| 入力機器 | キーボード | スタンダード・キーボード ※USB 接続 |

| マウス | オプティカル・マウス ※USB 接続 | |

| ラックマウント | サイズ | 19 インチ | 4U ラックマウント |

| レール・キット | 有償オプション | |

| 保証 | 期間 | 3 年間 |

| 方式 | センドバック方式ハードウェア保証 | |

ビジネス・スタンダード PC

モニターの背面に取り付け可能

業務用途から開発・制御用途で活躍

CAD/CAM/CAE 用途で活躍

専門性を追求したファクトリー向けPC

お客様の業務を安定継続させるPC

データを護る特別設計